در عصر هوش مصنوعی، یکی از برجستهترین بازرسان فدرال حوادث، دربارهٔ تأثیر احتمالی این فناوری بر عموم مردم پس از وقوع فجایع نگران است.

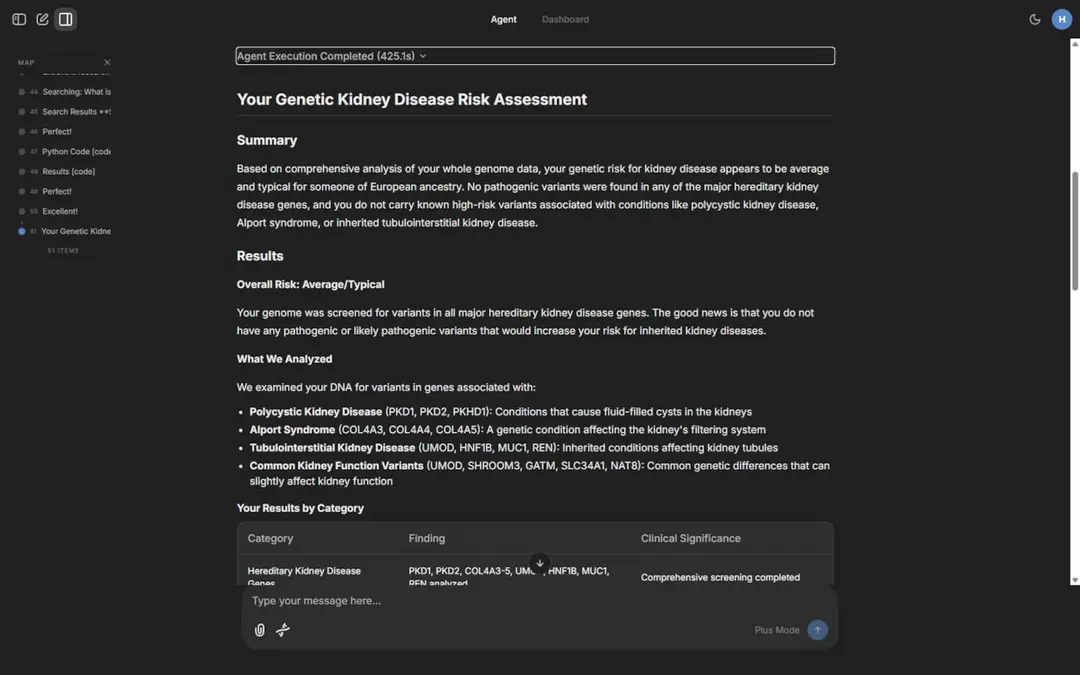

تصویری شامل پست X که دیگر در دسترس نیست، از یک تصویر مشکوک بهدستآمده توسط هوش مصنوعی از سقوط هواپیمای ژانویه در واشینگتن. | تصویر توسط بیل کوچمن/POLITICO (منبع تصویر از X)

توسط سام اوگوزالک

حدود ۱۱ ساعت پس از بزرگترین فاجعه هوایی کشور در بیش از دو دهه، یک کاربر X تصویر دراماتیکی از نجاتبخشانی که بر فراز بقایای سقوط در رودخانهٔ پوتاماک میرفتند، به همراه نورهای اضطراری که آسمان شب را روشن میکردند، منتشر کرد.

اما این واقعی نبود.

این تصویر که پس از سقوط مرگبار ژانویه بین یک جت منطقهای و هلیکوپتر بلکهاک ارتش، بیش از ۲۱٬۰۰۰ بازدید دریافت کرد، با عکسهای بدنهٔ خراب شدهای که پس از فاجعهٔ ۲۹ ژانویه گرفته شدهاند — یا مشاهدات افسران پلیس واشنگتن که به صحنه واکنش نشان دادند — که توسط سخنگوی ادارهٔ پلیس، تام لینچ، بیان شد، مطابقت ندارد.

یک بررسی خبرگزاری بهسرعت این تصویر را بهعنوان جعل شناسایی کرد — احتمالاً با استفاده از هوش مصنوعی، بر پایهٔ «DeepFake‑o‑meter» توسعهیافته توسط دانشگاه بوفالو. سه ابزار تشخیص هوش مصنوعی که توسط POLITICO به کار رفتهاند نیز آن را بهعنوان محتملاً تولید شده توسط هوش مصنوعی علامتگذاری کردند. این پست دیگر در دسترس نیست؛ X میگوید حساب کاربری معلق شده است.

اما این تصویر یک مورد منزوی در فضای آنلاین نیست. بررسی POLITICO شواهدی یافت که محتوای تولیدشده توسط هوش مصنوعی بهصورت روال در پی فجایع حملونقل در حال ظاهر شدن است، از جمله پس از سقوط هواپیمای باری UPS که در اوایل این ماه ۱۴ نفر را کشته بود. پستهای مرتبط با حوادث هوایی که در این داستان برجسته شدهاند، از کاربران بودند که به درخواستهای نظرسنجی برای اظهار نظر پاسخ ندادند.

پدیدهٔ رو به رشد این امر متخصصانی مانند جنیفر هومندی، برترین بازرس حوادث حملونقل کشور، را نگران میکند.

«من بسیار نگرانم که با استفاده از هوش مصنوعی، واقعاً میتواند درک عمومی و مسافران را تحت تأثیر قرار دهد»، جنیفر هومندی، رئیس هیئت ملی ایمنی حملونقل (NTSB)، در یک انجمن خلبانان خطوط هوایی (ALPA) در سپتامبر گفت. NTSB در حال پیگیری تحقیقی یکساله دربارهٔ علل فاجعهٔ ژانویه در واشنگتن است که منجر به مرگ ۶۷ نفر شد.

مشاور ایمنی هوانوردی جف گوزتی تأیید کرد و گفت که انتشار محتوای ایجادشده توسط هوش مصنوعی بهسرعت پس از یک سقوط میتواند گسترش اطلاعات نادرست را افزایش داده و «یکپارچگی تحقیق واقعی را زیر سؤال ببرد».

بدترین سناریو این است که «بهدلیل حواسپرتی همه، پیشگیری از حادثهٔ بعدی بهتأخیر افتد»، گفت گوزتی، که پیشتر مقامات بلندپایهای در NTSB و اداره فدرال هوانوردی (FAA) بود.

اما او پاسخی ساده برای اینکه FAA چگونه میتواند به محتوای مبتنی بر هوش مصنوعی در شبکههای اجتماعی واکنش نشان دهد نداشت و گفت که این امر نیاز به راهحلی «کلدولت» دارد.

در بیانیهای، این سازمان هوانوردی بیان کرد که «کارزارهای اطلاعات نادرست میتوانند خطرات ایمنی را افزایش داده و اعتماد عمومی را تضعیف کنند»، و افزود که از «تمام روشها و پلتفرمهای موجود برای ارائه بهروزرسانیهای دقیق و لحظهای به مردم» استفاده مینماید.

‘متن بیمعنی’

اما تقلبها همچنان ادامه دارند.

استاد علوم کامپیوتر و مهندسی دانشگاه بوفالو، سیوئی لیو، به ضبط ۹۱۱ ادعایی از سقوط پل فرانسس اسکات کی در سال گذشته در بالتیمور که پس از فاجعه بهسرعت در شبکههای اجتماعی پخش شد و ادعا میشد از یک راننده بود که خودروش پس از سقوط در آب در حال غرق شدن بود، اشاره کرد. او گفت ممکن است این صدا توسط هوش مصنوعی ساخته شده باشد — با یک «نشانه واضح» یعنی «قالب آرام گفتوگو که با اضطراری بودن وضعیت سازگار نیست».

بهتازگی، POLITICO ویدئویی که بهنظر میرسید توسط هوش مصنوعی تولید شده، در TikTok از سقوط یک هواپیمای باربری UPS در لوییویل، کنتاکی، و کنفرانس خبری بعدی NTSB دربارهٔ حادثه اوایل نوامبر یافت. دو ابزار تشخیص هوش مصنوعی که توسط POLITICO بهکار رفتهاند، این محتوا را بهعنوان احتمالاً ساختهشده توسط هوش مصنوعی علامتگذاری کردند.

تماشا: گفتوگو

هنگامی که این ویدئو که شامل تصاویری با وضوح بالا از نمای زیرین هواپیمای سوختگی هنگام پرواز است، برای وی ارسال شد، سخنگوی NTSB، پیتر نادسون، اشاره کرد که این ویدئو بخشی از جلسه مطبوعاتی برگزار شده توسط هیئت ایمنی را نشان میدهد، اما در نهایت مطمئن نبود که آیا آن بخش با هوش مصنوعی ساخته شده است یا خیر.

رئیس هیئت ملی ایمنی حملونقل، جنیفر هومندی، در یک نشست هیئت در ماه ژوئیه. او در حال هشدار دادن دربارهٔ جعلیهای فاجعهای است. | Rod Lamkey Jr./AP

اما طبق گفتهٔ لیو، این ویدئو از چندین کلیپ ۴ تا ۵ ثانیهای تولیدشده توسط هوش مصنوعی «بههم پیوسته» و همراه با روایت متن‑به‑صدا مصنوعی تشکیل شده است.

«محتوا شامل بسیاری از آثار آشکار هوش مصنوعی است، از جمله جابجاییهای آتش که با حوادث واقعی ناسازگار است، اشیاء بهصورت ناگهانی ظاهر میشوند، عناصر پسزمینه ثابت یا ناسازگار، علامتگذاری نادرست هواپیما، صحنههای جغرافیایی نادرست، و جزئیات توهمی مانند چراغهای تقلبی پلیس و متن بیمعنی روی جعبهسیاه»، لیو گفت.

او بهعنوان مثال اشاره کرد که یک هواپیما در ویدئو در میانهٔ هوا ثابت ماند، در حالی که عزاداران نزدیک به یک نرده جمع میشدند، و در حین کنفرانس خبری NTSB، مردی در پسزمینه «تغییر غیرطبیعی دست را نشان میداد؛ انگشتان و مچ دست او بهسرعت شکل میگیرند».

نویسندهای که نام کاربریاش «pulsenewsreels» است، به درخواست برای نظرآفرینی پاسخی نداد، هرچند توضیح حساب کاربری میگوید: «بر پایهٔ حقایقی که در زمان تهیهٔ این ویدئوها میدانستیم».

‘این واقعی نیست’

حتی NTSB نیز میتواند فریب بخورد.

هومندی، در حال سخنرانی در انجمن ALPA، به یاد آورد که پس از سقوط هواپیمای ایر اینڈیا در ماه ژوئن در احمدآباد، هند، که ۲۶۰ نفر کشته شد، «کسی از واحدهای عملیاتی ما … به من نزدیک شد و گفت: «آیا ویدئوی ایر اینڈیا را دیدی؟» من هم گفتم: «ای خدای من، چه ویدئویی؟» … او به من نشان داد و من گفتم: «این واقعی نیست».

«مردم به این مطالب باور میکنند»، هومندی گفت.

POLITICO چندین مثال از محتوای ظاهراً تولیدشده توسط هوش مصنوعی مرتبط با حادثه ایر اینڈیا پیدا کرد.

بهعنوان مثال، یک ویدئوی در TikTok آنقدر واقعی بود که حتی سه ابزار بررسی هوش مصنوعی موجود آنلاین در ارزیابی اینکه آیا توسط ماشین ساخته شده است یا نه، نظرات متفاوتی ارائه دادند (یکی گفت احتمالاً بله؛ دو دیگری مخالفت کردند). اما این تصویر با عکسهای واقعی فاجعه که توسط سرویس خبری بینالمللی معتبر ریتورز منتشر شده بود، مطابقت ندارد.

نویسندهای که با نام «drsun0715» شناخته میشود، به درخواست برای نظرآفرینی پاسخی نداد و TikTok نیز پاسخی نداد. این ویدئو هماکنون در دسترس نیست.

در مورد سقوط ژانویه نزدیک فرودگاه ملی واشنگتن رونالد ریگان، ابزارهای تشخیص هوش مصنوعی تنها نشانهای نبودند که نشان دهند تصویر ادعایی واقعی نیست. لیو از دانشگاه بوفالو همچنین به «چند نکتهٔ عجیب» در آن اشاره کرد؛ از جمله «اشکال انسانی مبهم»، شخصی با نسبت سر به بدن که طبیعی به نظر نمیرسد و «بازتاب نور آبی مرموز» بر سطح آب.

هنگامی که تصویر نمایش داده شد، سخنگوی NTSB، اریک وایس، افزود که شیشهٔ جلویی هواپیما شبیه شیشهٔ یک مکدونل‑داگلاس DC‑10 به نظر میرسید؛ یک جت بسیار بزرگتر از بومباردیِر CRJ‑700 که در برخورد حضور داشت.

کاربری که تصویر را به اشتراک گذاشت و با نام «254Debug» شناخته میشود، به درخواست برای نظرآفرینی پاسخی نداد. X نیز پاسخی نداد، هرچند حساب کاربری این فرد در حال حاضر معلق شده است. دلیل این مسأله واضح نیست.

پست دیگر قابل مشاهده نیست.