اروپا میخواهد تنظیمگری کند، در حالی که دولت ایالات متحده به شرکتها اجازه میدهد آزادانه عمل کنند. دلایل این رویکردهای متفاوت به یک قرن پیش باز میگردد.

نوشته کالر مکیوف

تصاویر توسط نیکلاس ارگتا برای POLITICO

یک دانشجوی جوان آمریکایی پیامی از یک عامل هوش مصنوعی دریافت میکند: «استنفورد فقط ایمیلی فرستاد و پرسید کجا میخواهی برای تحصیل در خارج بروی». پس از اینکه پرسید «اُه… کجا باید بروم» و به برنامه برگشت و پاریس را انتخاب کرد، ترم را آغاز میکند؛ ابتدا با پایتخت اروپا سردرگم میشود و سپس عاشق میشود؛ چرا که با یک دختر فرانسوی آشنا میشود، به پیکنیکها و سینما میرود، همه اینها با کمک دوست قابل اعتماد هوش مصنوعیاش. وقتی ترم به پایان میرسد، برای کمک میگوید: «میتوانی بلیط پرواز برگشتم را بررسی کنی؟» عامل هوش مصنوعی پاسخ میدهد: «صبر کن، نه. چرا میخواهی برگردی مرد؟» سپس جوان میگوید: «؟؟». هوش مصنوعی میگوید: «در پاریس بمان». و تصمیم نهایی گرفته میشود: او از تلفناش نگاه میکند و دست خود را دور شانهٔ دوست دختر فرانسویاش میگیرد.

این تبادل به یک تبلیغ ۲ دقیقه و ۳۷ ثانیهای برای Poke.com تبدیل شده است، برنامهای هوش مصنوعی که بین یک دستیار شخصی و یک دوست دانا قرار میگیرد و توسط استارتاپ Interaction ساخته شده است. اما به طرز عجیبی، حتی وقتی این برنامه روی رویای آمریکاییها برای رفتن به اروپا میفروشد، خود شرکت زمانی شکل گرفت که برعکس آن اتفاق افتاد: Interaction توسط مهاجران آلمانی در کالیفرنیا اداره میشود.

این شرکت آمریکایی تحت رهبری اروپایی نمونهای از مشکلی است که تصمیمگیرندگان و حامیان فناوری در اروپا را به خود مشغول کرده است: اگرچه قاره میتواند ایدهها و استعدادهای لازم برای ساخت برنامههای جدید هوش مصنوعی را تولید کند، اما به ندرت جایی میشود که این ایدهها در مقیاس بزرگ پیاده شوند.

«هر کجا در جهان باشید — اروپا یا آسیا یا هر کجا — همه فقط میخواهند به خلیجساحلی (Bay Area) بیایند، تا زمانی که در هوش مصنوعی باشید»، میگوید ماروین فون هاگن، یکی از همبنیانگذاران Interaction. دادهها ادعای فون هاگن را تأیید میکنند. بر اساس گزارشی از شرکت سرمایهگذاری Accel، ۸۰ درصد سرمایهگذاری در هوش مصنوعی مولد در ایالات متحده، اروپا و اسرائیل در سالهای ۲۰۲۳ و ۲۰۲۴ به شرکتهای آمریکایی اختصاص یافت. در سال ۲۰۲۴، ایالات متحده ۴۰ «مدل هوش مصنوعی قابل توجه» تولید کرد، در مقابل ۱۵ مدل در چین و تنها سه مدل در اروپا، طبق گزارش شاخص هوش مصنوعی ۲۰۲۵ از دانشگاه استنفورد. یازده درصد از تمام شرکتهای فناوری ایالات متحده بنیادگذاران اروپایی دارند، و صدها شرکت نویدبخش که در اروپا آغاز شدهاند — بسیاری از آنها مستقیماً مرتبط با هوش مصنوعی هستند — به ایالات متحده منتقل شدهاند.

«افرادی که میخواهند بخشی از این انقلاب هوش مصنوعی باشند به اینجا (ایالات متحده) میآیند»، گفت فلورین ژونگرمان، مهاجر آلمانی دیگر و همبنیانگذار Listen Labs، شرکتی هوش مصنوعی برای تحقیق در زمینه مشتریان. «در واقع کمی برای آلمان ناراحت هستم.»

کارآفرینان فناوری که بر روی شرکتهای هوش مصنوعی کار میکنند به دلایل متعددی به ایالات متحده میروند، که برخی از آنها خود تقویتکننده هستند: سیلیکونوالی پر از شرکتهای هوش مصنوعی است، که ساخت یک شرکت هوش مصنوعی را در آنجا آسانتر میکند. در ایالات متحده صندوقهای سرمایهگذاری خطرپذیر بیشتری وجود دارند و علاقهمند به سرمایهگذاری در محصولات ناشناختهتر هستند. اما یک دلیل بزرگ دیگر نیز وجود دارد که به گفته بسیاری از خود مؤسسان و حامیان هوش مصنوعی در اروپا بیان میشود: افراد فناوری اغلب نسبت به مقررات با شک و تردید عمیق نگاه میکنند — و اروپا بهطور واضح دارای مقررات فراوانی است، بهویژه در زمینه هوش مصنوعی.

در ماههای اخیر، شرکتهای فناوری مستقر در اروپا، همراه با برخی دولهای ملی و خود کمیسیون اتحادیه اروپا، سعی در کاهش بار مقرراتی بر شرکتهای هوش مصنوعی داشتهاند، با به تعویق انداختن بخشهای کلیدی اجرای قانونگذاری یا حمایت از اینکه اتحادیه اروپا چارچوب کلی خود را بازنگری کند. اما اختلافات بین اروپا و ایالات متحده در زمینه مقررات هوش مصنوعی بهسادگی قابل حل نیست؛ این اختلافات ریشه در تفاوتهای عمیق فرهنگی دارد که شکلگیری صنایع فناوری را در هر دو قاره تحت تأثیر قرار دادهاند.

دانشمندان و اعضای صنعت بهطور مشترک میگویند که تغییر این فرهنگ برای اروپا برای بهدستآوردن سرعت لازم حیاتی است، هم در زمینه نگهداشتن بیشتر متخصصان هوش مصنوعی در قاره و هم تشویق آنهایی که میمانند به کارآفرینی بیشتر.

«امروزه، کشورهای اروپایی مانند آلمان هنوز استعدادهای برجستهای را در اختیار دارند»، گفت رابرت ویندشیم، سرمایهگذار آلمانی در صندوق بنیادهای مؤسس (Founders Fund) مستقر در سانفرانسیسکو، «اما اغلب محیط فرهنگیای که این استعدادها را قادر سازد تا انرژی خود را به ایجاد شرکتهای جدید هدایت کنند، ندارند.»

سابقه

اتحادیه اروپا برای دههها بیشتر از ایالات متحده به تنظیمگری در صنایع مختلف متعهد بوده است. و بهعنوانکه اروپا یک مدل رشدی تا حدی کندتر و ایمنتر را برگزیده، افراد جوان و پرشور که با محدودیتهای بوروکراتیک روبرو میشوند، دچار ناامیدی میشوند.

اما دقیقاً چرا اتحادیه اروپا درک متفاوتی از نقش دولت دارد — بهویژه در رابطه با هوش مصنوعی — یک سؤال گستردهتر است که به دل وقایع تاریخی و تفاوتهای فرهنگی میان اقیانوس اطلس میپردازد.

بخش زیادی به حریم خصوصی مربوط میشود. «اولین چیزی که بسیاری از مردم اروپا وقتی درباره فناوری فکر میکنند، این است که «آنها به ما جاسوسی میکنند» یا «این فناوری بهصورت منفی استفاده میشود»،» میگوید ژونگرمان. «بهعنوان مثال، در آلمان مردم شماره تلفن خود را بهراحتی در اختیار دیگران نمیگذارند. آنها شماره تلفن خود را محافظت میکنند؛ همانطور که مردم در ایالات متحده شماره تأمین اجتماعی خود را محافظت میکنند.»

بهدرستی میگوید آنو برادفورد، استاد دانشگاه کلمبیا که بهتحقیق در مورد دولت تنظیم دیجیتال اتحادیه اروپا میپردازد — و خود بهطور عمده حامی مقررات اروپا در زمینه هوش مصنوعی است — بخشی از این مسأله را میتوان تقریباً یک قرن بهعقب ردیابی کرد. «باید به دلایل تاریخی و جنگ جهانی دوم فکر کنید و اینکه نازیها چگونه برای شناسایی یهودیان از اطلاعات استفاده کردند — این یک نقض حق حریم خصوصی بود»، او میگوید. «به نظارت استاسی در آلمان شرقی فکر کنید. اروپاییها میدانند که وقتی حریم خصوصی ندارید … آنها بهدلیل دلایل فرهنگی نسبت به این موضوع حساسیت بالایی دارند.»

دین بال، نویسندهٔ اصلی برنامهٔ اقدام هوش مصنوعی دولت ترامپ، موافقت کمی با برادفورد دربارهٔ مقررات دارد. اما او نیز تفاوتهای فرهنگی بین دو طرف را به اواسط قرن بیستم ردیابی میکند. بهنظر او اتحادیه اروپا «وضعیت فعلی را در حالت رنگ آمبر (زرد) حفظ کرده» و با ذهنیت قرن بیستم برای حل مشکلات قرن بیست و یکم عمل میکند.

ویندشیم، که خود زادهٔ اروپا است، نیز ترسهای ایمنی را به بحرانهای قرن گذشته ربط میدهد. «فاجعههای قرن بیستم اروپا ذهنیتی ماندگار و بهدرستی محتاطانه بهوجود آوردهاند. محافظت در برابر خطر و ایمنی بهنقطهٔ عطف تبدیل شد»، او میگوید. بهنظر او، اروپاییها بهطور عمده ارزیابی ریسک متفاوتی نسبت به فناوری اتخاذ کردهاند و این را بهقانون تبدیل کردهاند، در مقایسه با دولت آمریکا.

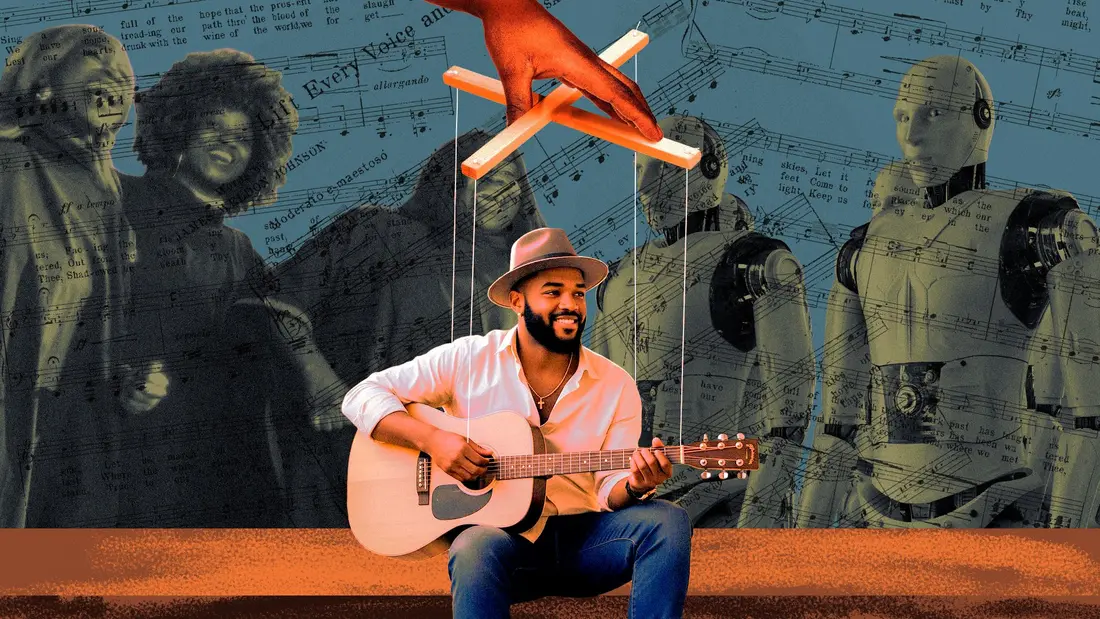

سیلیکونوالی، که خود فرهنگی دارد که با بسیاری از مردم آمریکا و اروپا همسو نیست — و این فرهنگ بقیهٔ رویکردهای آمریکایی نسبت به فناوری را شکل داده است —، بهطولانیمدت توسط یک ایدئولوژی لیبرالیگرایانه و ایمان راسخ به پیشرفت تکنولوژی هدایت میشود، نه نیروهایی که ممکن است آن را محدود کنند. «با وجود نقش مرکزی مداخلهٔ عمومی در توسعهٔ هیپرمیدیا، نظریهپردازان کالیفرنیایی یک انجیل ضددولتگرایانه از لیبرالیگری پیشرفتهٔ فناوری را تبلیغ میکنند: ترکیبی عجیب از انارشیسم هیپی و لبیسم اقتصادی که با تعیینگرایی تکنولوژیک تقویت میشود»، دو نظریهساز رسانهای در مقالهٔ مهم «ایدئولوژی کالیفرنیا» برای Whole Earth Catalog در اوسط دههٔ ۹۰ نوشتند.

یکی از پرطرفدارترین مفاهیم که در جامعهٔ خلیج در حال حاضر جریان دارد، ایدهٔ «شتابگرایی» است. این فلسفه شامل جریانات فکری مختلفی میشود: از اینکه (و امید داشته) توسعهٔ غیرقابلقید و بند هوش مصنوعی منجر به یک تکنو‑اتوتوپی میشود که در آن ماشینها بیماریها را حل میکنند، تا اینکه (و امید داشته) هوش مصنوعی دموکراسی را نابود میکند و دنیایی را بهوجود میآورد که در آن تعداد بسیار کمی از حاکمان فناوری بهصورت مطلق بر جهان حکمرانی میکنند. این دیدگاههای مختلف بهطوری چشمگیر به ایجاد فرهنگهای مختلف تنظیمگری در فناوری در ایالات متحده و اتحادیه اروپا در طول قرن بیستم و بیست و یکم منجر شدند. مقررات عمومی حفاظت از دادهها (GDPR) اتحادیه اروپا، قانون جامع حریم خصوصی که در سال ۲۰۱۸ اجرا شد، حقی به حریم خصوصی میبخشد که در ایالات متحده وجود ندارد — و توانایی شرکتهای فناوری در جمعآوری دادهها و کسب درآمد از آن را محدود میکند، که پیامدهای عظیمی برای توان رشد شرکتهای فناوری در اروپا داشته است.

«بسیار از خودبینی، غرور و [ اروپا ] واقعا این ذهنیت را دارد که باید تنظیمکنندهٔ جهان باشد، اما این کار را قبل از آنکه فناوری واقعاً توسعه یابد، انجام میدهند»، میگوید مایکل جکسون، سرمایهگذار آمریکایی در حوزه فناوری که در پاریس زندگی و کار میکند. این در مقایسه با ایالات متحده است، جایی که بهگفته او، دولت پس از درک نیازهای بازار، با مقررات هدفمندتر وارد میشود.

هوش مصنوعی این تفاوتها را واضحتر از همیشه نشان داد. هوش مصنوعی چالشهای بزرگتری برای حریم خصوصی ایجاد میکند و فرصتهای بیشتری برای نظارت فراهم میسازد، و پیامدهای آن سختتر پیشبینی میشود تا تقریباً هر نوآوری دیگری که پیش از آن آمده است، بهاستثنای اینترنت — که برای افراد ریسکگریز یک کابوس است.

اروپا رویکردی واضحاً سختگیرانهتر در تنظیمگری اتخاذ کرده است. قانون هوش مصنوعی — که در ۱ اوت ۲۰۲۴ در اتحادیه اروپا به اجرا درآمد — سعی دارد بیشترین تلاش خود را برای مهار شرکتهای هوش مصنوعی که بهنفع عمومی عمل نمیکنند، انجام دهد. بهطور عمده، این قانون بر کاهش خطرات تمرکز دارد. ردهبندیهای خطر برای برنامههای هوش مصنوعی ایجاد میکند — از «حداقل» تا «غیرقابلقبول» (برنامههایی که این دستهبندی دریافت میکنند ممنوع میشوند) — و بیشتر شرکتهای هوش مصنوعی را ملزم میکند تا شفافیت بیشتری دربارهٔ نحوهٔ کار خود داشته باشند.

در همان زمان، پس از برخی تلاشهای متوقفشده برای تنظیم هوش مصنوعی در دورهٔ جو بایدن، ایالات متحده تحت رهبری دونالد ترامپ مقررات را کنار گذاشت. در ژوئیه، دولت ترامپ برنامهٔ اقدام هوش مصنوعی (AI Action Plan) را منتشر کرد؛ مجموعهای از ترجیحات سیاستی که وعده داد «داردگی بوروکراسی و مقررات سختگیرانهٔ توسعهٔ هوش مصنوعی را حذف کند». همانطور که اتحادیه اروپا بهسختی بیشتر تنظیم میکند، آمریکا کمتر تنظیم میکند. و با توسعهٔ این فاصله، تعداد مؤسسان در هر دو مکان نیز افزایش مییابد.

همچنین دلایل جدیدی برای اینکه اروپا به تنظیمات فکر کند، بوجود آمده است. «موفقیت آمریکایی این نیاز را برای اروپا تقویت کرده، زیرا اکنون به شدت وابسته به فناوریای هستید که صاحب آن نیستید و کنترل آن را ندارید»، میگوید ماریاروزاریا تادئو، ایتالیایی که هماکنون استاد اخلاق دیجیتال و فناوری دفاعی در موسسهٔ اینترنت آکسفورد در بریتانیا است.

اتحادیه اروپا باید بیشتر به تحریک توسعهٔ فناوری فکر کند، او افزود، زیرا مطمئن نیست که اهداف نهایی غولهای فناوری آمریکایی چیست — و تا چه حد باید در برابر یک شرکت خصوصی که منافع شهروندان اروپا را در نظر ندارد مبارزه کند.

«اروپا در موقعیت ضعیفی قرار دارد، زیرا بیشتر توسعهدهندگان در جهان آمریکاییاند»، میگوید برادفورد. «در حال حاضر دشوارتر میشود، اگر اتحادیه اروپا بخواهد بهتنهایی جهان را تنظیم کند و اگر آمریکاییها خود را تنظیم نکنند.»

فراتر از روایت

حامیان چارچوب اروپایی ادعا میکنند که در مقابل مهار نوآوری، این چارچوب صرفاً فناوری نوظهور و سریعاً در حال رشد را برای کاربران و مؤسسان ایمنتر میکند. در واقع، آنها با این تصور که تنظیم و نوآوری در تقابل هستند، بهطوردیگر مواجه میشوند.

«من نمیخواهم این تصور پیش بیاید که برای نوآوری باید مدل «دستنهاده» آمریکایی را انتخاب کنید، و مدل اروپایی بهنحوی اساسی با نوآوری ناسازگار باشد»، میگوید برادفورد. «این یک روایت ساده است که میگوید «چون آنها خیلی تنظیم میکنند، نوآوری وجود ندارد». این دلیل نیست که چرا اروپاییها از نوآوری هوش مصنوعی پیشی نمیگیرند.»

برادفورد به دشواری داشتن ۲۷ حوزه قضایی بدون یک بازار متحد واحد اشاره کرد؛ یکی از دلایل عمدهای است که توسعهٔ هوش مصنوعی در اتحادیه اروپا ساده نیست — نکتهای که بسیاری از حامیان ضد تنظیم و مؤسسان فناوری نیز با آن موافقت میکنند.

علاوهبر این، سرمایهگذاری بیشتری در آمریکا موجود است. سرمایهگذاران خطرپذیر پولهای خود را به شرکتهای فناوری مستقر در ایالات متحده میریزند و تمایل کمتری به سرمایهگذاری در شرکتهای دیگر مناطق نشان میدهند — بین سالهای ۲۰۱۳ تا ۲۰۲۲، شرکتهای مستقر در اتحادیه اروپا $1.4 تریلیون کمتر نسبت به شرکتهای مستقر در ایالات متحده جذب سرمایه سرمایهگذاری خطرپذیر کردند.

اروپا همچنین تنها جایی نیست که دولت تنظیمگری در حال رشد است.

در حقیقت، اگرچه واشنگتن ممکن است در صدد استفاده از محدودیتها برای هوش مصنوعی نباشد، ایالت کالیفرنیا گامهای موثری برداشته و چندین رهنمود هوش مصنوعی را اجرا میکند که کار مشابهی دارد. یکی از دلایل این است که آمریکاییها نیز از هوش مصنوعی بدون تنظیم میترسند — بر اساس نظرسنجی گالاپ انجامشده در آوریل و مه ۲۰۲۵، ۸۰ درصد آمریکاییها معتقدند که باید قوانین ایمنی و امنیت دادهها برای هوش مصنوعی حفظ شود، حتی اگر این به معنای توسعهٔ هوش مصنوعی با سرعت کمتر باشد.

«نظر من این است که آمریکاییها و اروپاییها در حوزهٔ حاکمیت هوش مصنوعی بهطور نزدیک همسو هستند. اگر به دادههای نظرسنجی، نگرانیهای مربوط به حق نسخهبرداری، حریم خصوصی و جابجایی نیروی کار نگاه کنید، این موارد بهطور مساوی در هر دو منطقه مشهود است»، میگوید مارک روننبرگ، رئیس و مؤسس مرکز هوش مصنوعی و سیاست دیجیتال در واشنگتن. «کاخ سفید موضعی در مورد تنظیم هوش مصنوعی اتخاذ کرده که با بیشتر آمریکاییها، با بیشتر قانونگذاران ایالتی، و حتی با مواضعی که قبلاً داشتند، همراستا نیست.»

برای خوشبینان اروپایی، برخی نشانهها وجود دارد که اگرچه حاکمیت ممکن است کامل نباشد، تنظیمات مانع نوآوری نمیشود و اروپا شروع به یافتن جایگاه خود در زمینهٔ توسعهٔ هوش مصنوعی کرده است.

«هوش مصنوعی ناپدید نخواهد شد. در ده سال آینده نخواهد رفت… شما نیازی ندارید که در هوش مصنوعی اولین باشید. باید در هوش مصنوعی مقاوم، قدرتمند و قابل اعتماد باشید»، میگوید تادئو.

حتی اگر اروپا رویکرد تنظیمی قویتری اتخاذ کند، در عین حال برای ورود به این عرصه نیز تلاش میکند. در نوامبر، کمیسیون اروپا €200 میلیارد برای سرمایهگذاری در هوش مصنوعی اختصاص داد و رئیسجمهور فرانسه، امینوال ماکرون، تعهد به سرمایهگذاری خصوصی €109 میلیارد در این بخش اعلام کرد. در بهویژه کشورهای نوردیک، سرمایهگذاری دولتی به نوآوری و شرکتهای موفق رشددهنده منجر شده است. تا کنون، هیچ دولتی اروپایی بهصورت مستقیم بهدنبال تنظیمگری دولت نیامده است.

اما هنگامی که قاره سعی میکند رویکرد خود را برای ساخت شرکتهایی که بهطرز چشمگیری متفاوت از سیلیکونوالی هستند، سؤال این است که آیا آنها برای تأثیرگذاری دیگر دیر کردهاند — آیا بخشهای خوب جشن دیگر تمام شدهاند.

«آنها پنج سال پیش دیر کردند و اکنون هم بهطرز قطعاً دیر کردهاند»، میگوید بال.